С сегодняшнего дня наша компания (Wave Computing) начинает поставлять заказчикам вычислители для искусственного интеллекта и машинного обучения.

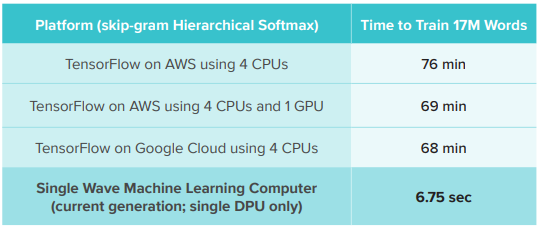

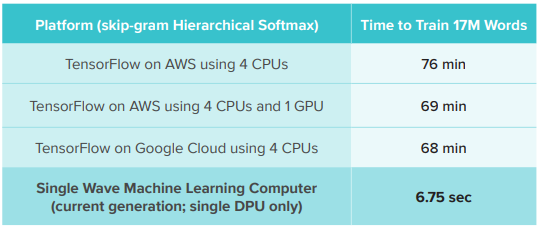

Скорость на стандартных тестах примерно в 600 раз выше, чем у облачных решений и GPU.

Спецификация вычислителя: WaveComputing_ProductBrief_6.7.0.pdf

Скорость на стандартных тестах примерно в 600 раз выше, чем у облачных решений и GPU.

Спецификация вычислителя: WaveComputing_ProductBrief_6.7.0.pdf

no subject

Date: 2018-06-26 22:08 (UTC)no subject

Date: 2018-06-27 00:50 (UTC)https://www.tensorflow.org/performance/benchmarks

no subject

Date: 2018-06-27 01:09 (UTC)no subject

Date: 2018-06-27 02:25 (UTC)Ряд вопросов:

- она показывает хорошие результаты только для TensorFlow?

- есть ли тесты для OpenCV и DLib?

- каков порядок стоимости вашего железа?

- ну и последний, просто интересно, на чем сделали: FPGA или уже ASIC?

А вообще, идея мне нравится. Привет Скайнет;)

no subject

Date: 2018-06-27 02:50 (UTC)Про стоимость я не в курсе, наши маркетологи объявят со временем.

Уже готовый ASIC с 16 тысячами процессоров на кристалле и скоростью 6 ГГц.

no subject

Date: 2018-06-27 02:54 (UTC)Маркетологам только скажите, что прирост в 10% на конфигурации с 1 GPU в таблице смотрится не очень реально. Должно быть больше.

no subject

Date: 2018-06-27 05:12 (UTC)no subject

Date: 2018-06-27 08:37 (UTC)no subject

Date: 2018-06-27 11:44 (UTC)no subject

Date: 2018-06-27 17:48 (UTC)https://wavecomp.ai/dataflow-whitepaper

https://wavecomp.ai/iccad17-wp

no subject

Date: 2018-06-27 17:49 (UTC)Но всё это пока не в открытом доступе.

no subject

Date: 2018-06-27 17:50 (UTC)no subject

Date: 2018-06-30 20:43 (UTC)Tensor Cores

Tesla P100 delivered considerably higher performance for training neural networks compared to the prior generation NVIDIA Maxwell and Kepler architectures, but the complexity and size of neural networks have continued to grow. New networks that have thousands of layers and millions of neurons demand even higher performance and faster training times.

New Tensor Cores are the most important feature of the Volta GV100 architecture to help deliver the performance required to train large neural networks. Tesla V100’s Tensor Cores deliver up to 125 Tensor TFLOPS for training and inference applications. Tensor Cores provide up to 12x higher peak TFLOPS on Tesla V100 for deep learning training compared to P100 FP32 operations, and for deep learning inference, up to 6x higher peak TFLOPS compared to P100 FP16 operations. The Tesla V100 GPU contains 640 Tensor Cores: 8 per SM.

Matrix-Matrix multiplication (BLAS GEMM) operations are at the core of neural network training and inferencing, and are used to multiply large matrices of input data and weights in the connected layers of the network. As Figure 6 shows, Tensor Cores in the Tesla V100 GPU boost the performance of these operations by more than 9x compared to the Pascal-based GP100 GPU.

no subject

Date: 2018-07-01 06:12 (UTC)